- Afhalen na 1 uur in een winkel met voorraad

- Gratis thuislevering in België vanaf € 30

- Ruim aanbod met 7 miljoen producten

- Afhalen na 1 uur in een winkel met voorraad

- Gratis thuislevering in België vanaf € 30

- Ruim aanbod met 7 miljoen producten

Zoeken

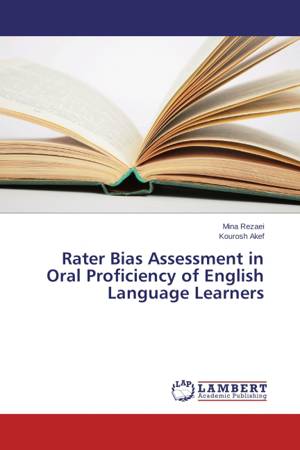

Rater Bias Assessment in Oral Proficiency of English Language Learners

Mina Rezaei, Kourosh Akef

Paperback | Engels

€ 48,95

+ 97 punten

Omschrijving

Rater bias is a substantial source of error in performance assessment, where raters rate examinees based on a designed rubric of a specified scale. Unfortunately, raters comprehension from the assessment criteria is dissimilar to each other despite the training sessions of using it, so that would be undermines the validity and reliability. In this study both students and teachers played a role as the raters. If such performance assessment can be shown to be valid and reliable, participating students in the process of rating could contribute to lessening the burden on teachers. This study surveyed to find whether there is any significant difference among these raters in their severity or leniency in relation to difficulty levels of descriptors in the rating scale and the ability of the students. The results of Facets analysis showed that there were bias interactions between assessor types, and these bias interactions were statistically significant.

Specificaties

Betrokkenen

- Auteur(s):

- Uitgeverij:

Inhoud

- Aantal bladzijden:

- 96

- Taal:

- Engels

Eigenschappen

- Productcode (EAN):

- 9783659590344

- Verschijningsdatum:

- 19/08/2014

- Uitvoering:

- Paperback

- Afmetingen:

- 150 mm x 220 mm

- Gewicht:

- 150 g

Alleen bij Standaard Boekhandel

+ 97 punten op je klantenkaart van Standaard Boekhandel

Beoordelingen

We publiceren alleen reviews die voldoen aan de voorwaarden voor reviews. Bekijk onze voorwaarden voor reviews.