Bedankt voor het vertrouwen het afgelopen jaar! Om jou te bedanken bieden we GRATIS verzending (in België) aan op alles gedurende de hele maand januari.

- Afhalen na 1 uur in een winkel met voorraad

- In januari gratis thuislevering in België

- Ruim aanbod met 7 miljoen producten

Bedankt voor het vertrouwen het afgelopen jaar! Om jou te bedanken bieden we GRATIS verzending (in België) aan op alles gedurende de hele maand januari.

- Afhalen na 1 uur in een winkel met voorraad

- In januari gratis thuislevering in België

- Ruim aanbod met 7 miljoen producten

Zoeken

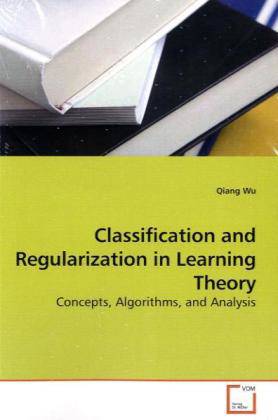

Classification and Regularization in Learning Theory

Concepts, Algorithms, and Analysis

Qiang Wu

Paperback | Engels

€ 58,45

+ 116 punten

Omschrijving

Over the last decade, statistical learning theory has achieved rapid progress due to the introduction and research of classification algorithms including support vector machines and boosting. Along with their successful applications in practice, theoretical performance of these algorithms becomes well understood in terms of margin bounds, Bayes risk consistency, and asymptotic rate analysis. This monograph provides further investigation of these algorithms within regularization frameworks and from an approximation theory point of view. Error analysis frameworks by error decomposition techniques are fully developed for two classes of regularization schemes which cover the support vector machines, regularized boosting, and support vector kernel networks by linear programming and indefinite kernels. The results presented in this monograph are by far the best. The error analysis frameworks have been shown to be wide applicable in most recent research works and should be able to shed light on future researches on related topics in machine learning and artificial intelligence.

Specificaties

Betrokkenen

- Auteur(s):

- Uitgeverij:

Inhoud

- Aantal bladzijden:

- 160

- Taal:

- Engels

Eigenschappen

- Productcode (EAN):

- 9783639198355

- Uitvoering:

- Paperback

- Gewicht:

- 222 g

Alleen bij Standaard Boekhandel

+ 116 punten op je klantenkaart van Standaard Boekhandel

Beoordelingen

We publiceren alleen reviews die voldoen aan de voorwaarden voor reviews. Bekijk onze voorwaarden voor reviews.